本帖最后由 三金 于 2020-1-28 02:59 编辑

先诉诉苦:

之前看各位大佬写插件,就很羡慕能自给自足,想干什么干什么

这两天刚好在玩node-red,发现写流程好像也能达到差不多的效果

但是搞了两天之后终于相信一个事实,我这样的不太可能在node-red的function里写出东西,还能达到我的目的!

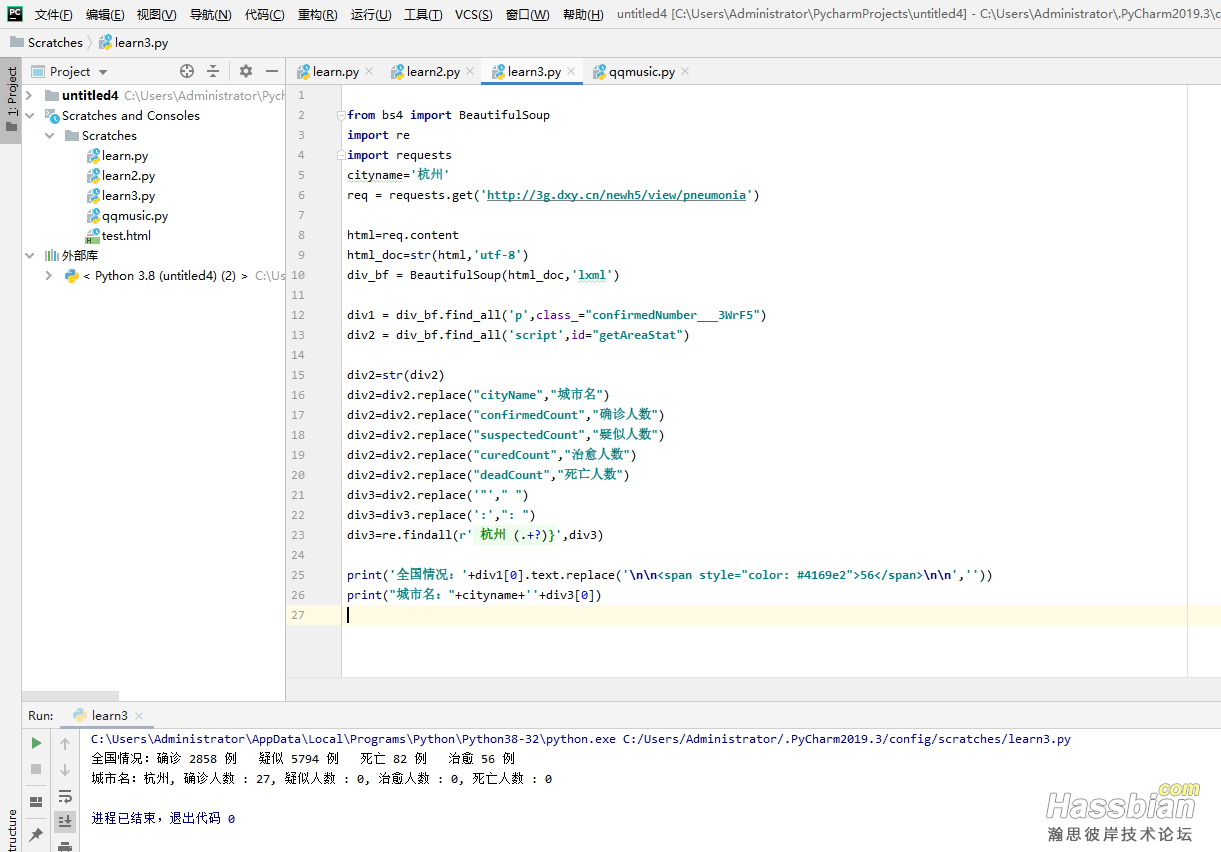

然后昨天下午开始接触python和html,从安装环境开始到半夜十二点才写出来一个简单的丁香园爬虫 不过还是有种成就感的,不发出来,全世界的人怎么知道我会写Python了呢? 不过还是有种成就感的,不发出来,全世界的人怎么知道我会写Python了呢?

本来想看看能不能做插件的,看了看各位大佬写的插件

嗯~~~

看不懂!!什么鬼东西绕七绕八的,走迷宫一样的!!

困得受不了,果断放弃,发完帖子去睡觉!!

打印如下:

丁香园连接:http://3g.dxy.cn/newh5/view/pneumonia

(ps:方糖公众号里知道的)

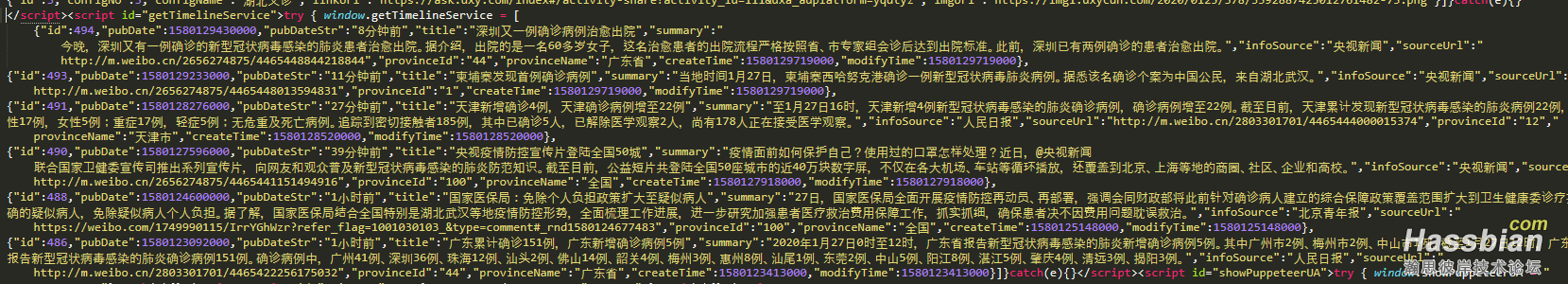

同理加上新闻标签就能打印新闻内容

(懒得加了)

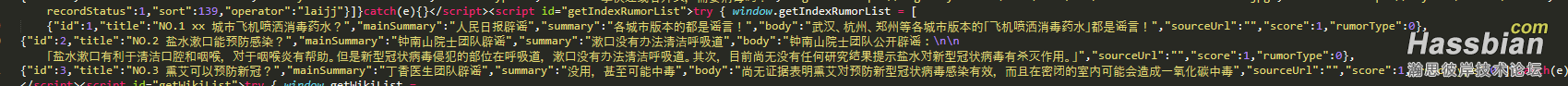

还有辟谣内容

还有辟谣内容

再诉诉苦:

太难了,搞个什劳子的编码格式就搞了半天,什么鬼玩意儿,能有那么多的类型?!!

然后有个问题:

正则表达式里怎么添加变量啊?

谷歌好些方法我都试过了,没一个能行的,头疼

以下是代码:我的环境好像有问题,格式要转来转去才行,不然一直报错,我也不知道为什么,然后我就在网上各种搜,算是拼出来的代码

import re

import requests

from bs4 import BeautifulSoup

cityname='杭州'

req = requests.get('http://3g.dxy.cn/newh5/view/pneumonia')

html=req.content

html_doc=str(html,'utf-8')

div_bf = BeautifulSoup(html_doc,'lxml')

div1 = div_bf.find_all('p',class_="confirmedNumber___3WrF5")

div2 = div_bf.find_all('script',id="getAreaStat")

div2=str(div2)

div2=div2.replace("cityName","城市名")

div2=div2.replace("confirmedCount","确诊人数")

div2=div2.replace("suspectedCount","疑似人数")

div2=div2.replace("curedCount","治愈人数")

div2=div2.replace("deadCount","死亡人数")

div3=div2.replace('"'," ")

div3=div3.replace(':',": ")

div3=re.findall(r' 杭州 (.+?)}',div3)

print('全国情况:'+div1[0].text.replace('\n\n<span style="color: #4169e2">56</span>\n\n',''))

print("城市名:"+cityname+''+div3[0])

不知哪位大佬能搞个通俗易懂的插件让小白我学习一下

|